Poate ChatGPT să prezică evenimente viitoare?

duminică, noiembrie 5, 2023 8:55Cunoscând datele trecute şi prezente, se pot prezice evenimente viitoare? Iată o întrebare la care cercetătorii din domeniul AI (Artificial Intelligence – Inteligenţă Artificială) încearcă să răspundă. Răspunsul ar fi util în multe domenii de activitate, cum ar fi domeniul medical, acolo unde, ştiind istoricul medical al unui pacient, s-ar putea spune dacă, în viitor, pacientul se va vindeca sau nu.

În limbaj ştiinţific, aceste preziceri înseamnă date în serie de timp – date care măsoară aceleași variabile în momente diferite, pentru a identifica tendințele. Abordările tradiţionale ale datelor din serii cronologice se concretizează în soft-uri specializate, special concepute pentru acest tip de date.

Dar prezentul înseamnă şi omniprezenţa inteligenţei artificiale, aşa încât cercetătorii încearcă să adauge AI-ului o nouă capacitate, aceea de a gestiona datele dintr-o serie temporală. Într-un nou studiu publicat în luna octombrie 2023 de Nate Gruver de la Universitatea din New York, studiu la care au lucrat şi colegii săi de la NYU și Carnegie Mellon, programul OpenAI GPT-3 este antrenat să prezică următorul eveniment într-o serie de date temporale, asemănător cu prezicerea următorului cuvânt dintr-o propoziție.

„Deoarece modelele lingvistice sunt construite pentru a reprezenta distribuții complexe de probabilitate pe secvențe, ele sunt, teoretic, potrivite pentru modelarea seriilor temporale”, scriu Gruver și membrii echipei sale în lucrarea lor, „Large Language Models Are Zero-Shot Time Series Forecasters”, publicată pe site-ul arXiv. „Datele din seria temporală iau de obicei exact aceeași formă ca datele de modelare a limbajului, ca o colecție de secvențe.”

Programul pe care l-au creat, LLMTime, este „extrem de simplu”, afirmă Gruver, și este capabil să „depășească sau să se potrivească cu metodele de serii cronologice create special pentru o serie de probleme diferite într-un mod zero, ceea ce înseamnă că LLMTime poate fi utilizat fără nicio reglare fină a datelor, aşa cum se întâmplă cu datele utilizate de alte modele.”

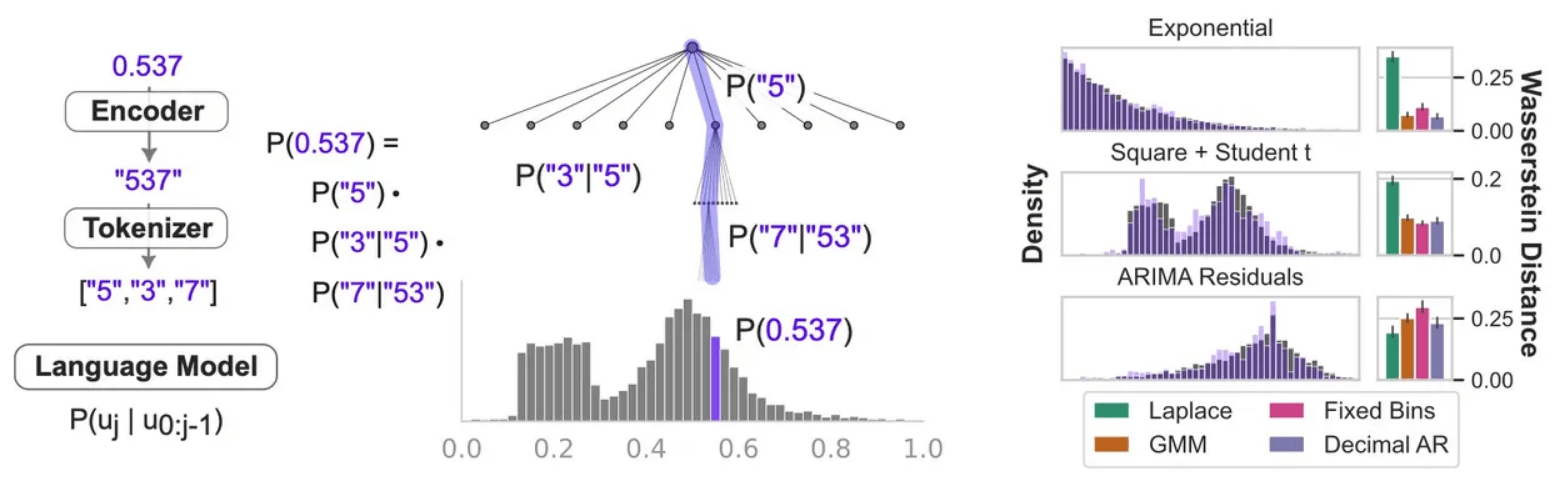

Cheia pentru construirea LLMTime a fost ca Gruver și colegii săi să regândească ceea ce se numește „tokenizare”, modul în care un model de limbaj mare reprezintă datele cu care lucrează. Programele, precum GPT-3, au un anumit mod în care introduc cuvinte și caractere, împărțindu-le în bucăți care pot fi ingerate pe rând. Datele din seria temporală sunt reprezentate ca șiruri de numere, cum ar fi „123”; seria temporală este doar modelul în care apar astfel de secvențe de cifre.

Având în vedere acest lucru, tokenizarea lui GPT-3 este problematică, deoarece adesea va sparge acele șiruri în grupări incomode. „De exemplu, numărul 42235630 este tokenizat ca [422, 35, 630] de către tokenizatorul GPT-3, iar modificările, chiar și cu o singură cifră, pot duce la o tokenizare complet diferită”, spun cercetătorii.

Pentru a evita aceste grupări incomode, Gruver și echipa sa au creat un cod pentru a introduce spațiu alb în jurul fiecărei cifre dintr-o secvență de cifre, astfel încât fiecare cifră să fie codificată separat. Apoi s-au apucat de antrenat GPT-3 pentru a prognoza următoarea secvență de cifre, în exemple reale de serii cronologice.

Orice serie cronologică este o secvență de lucruri care au loc unul după altul, cum ar fi „Câinele a sărit jos de pe canapea și a fugit la ușă”, unde există un eveniment și apoi altul. Un exemplu de set de date reale despre care oamenii doresc să facă predicții ar fi prezicerea retragerilor de la bancomate pe baza retragerilor istorice. O bancă ar fi foarte interesată să prezică astfel de lucruri.

Predicția retragerii bancomatelor este, de fapt, una dintre provocările unei competiții de serie în timp real, cum ar fi Competiția de previziune a rețelei neuronale artificiale și a inteligenței computaționale, organizată de Universitatea Lancaster din Marea Britanie. Acest set de date înseamnă, în limbaj ştiinţific, șiruri de numere, sub această formă:

T1: 1996-03-18 00-00-00 : 13.4070294784581, 14.7250566893424 etc.

Prima parte înseamnă, evident, data și ora pentru „T1”, reprezentând primul moment în timp, iar ceea ce urmează sunt sume (separate prin puncte, nu prin virgule, așa cum este cazul în notația europeană). Provocarea pentru o rețea neuronală este să prezică, având în vedere mii sau chiar milioane de astfel de date, ce s-ar întâmpla în clipa următoare după ultimul exemplu din serie – care va fi suma de bani retrasă de către clienți mâine.

Autorii studiului afirmă: „Nu numai că LLMTime este capabil să genereze completări plauzibile ale seriilor de timp reale și sintetice, ci atinge probabilități mai mari […] în evaluare decât modelele dedicate seriilor de timp […]”, care au fost create în ultimii zeci de ani.

Cu toate acestea, una dintre limitările modelelor mari de limbaj, subliniază Gruver și echipa sa, este că pot prelua doar un anumit număr date la un moment dat, cunoscută sub numele de „fereastra de context”. Pentru a gestiona serii de timp din ce în ce mai mari, programele vor trebui să extindă acea fereastră de context la mai multe jetoane. Acesta este un proiect explorat de numeroase echipe de cercetători, cum ar fi echipa Hyena de la Universitatea Stanford și Institutul MILA din Canada pentru AI și Microsoft, printre altele.

Întrebarea care se poate pune este de ce un model de limbaj mare ar trebui să fie bun la prezicerea numerelor. După cum notează autorii, pentru orice succesiune de numere, cum ar fi retragerile de la bancomate, există „în mod arbitrar multe reguli de generare care sunt în concordanță cu intrarea”. Adică, există atât de multe motive pentru care aceste șiruri de numere ar putea apărea, încât ar fi greu de ghicit care este regula de bază care explică apariţia acestor şiruri de numere.

Răspunsul este că GPT-3 și alte sisteme AI (Artificial Intelligence – Inteligenţă Artificială) găsesc regulile care sunt cele mai simple dintre toate regulile posibile. „LLM-urile pot prognoza eficient, deoarece preferă completările derivate din reguli simple, adoptând o formă de brici Occam”, scriu Gruver și echipa sa, referindu-se la principiul parcimoniei (parcimonie = zgârcenie).

Într-un al doilea experiment, Gruver și echipa sa au prezentat lui GPT-4 (succesorul mai puternic al lui GPT-3) un nou set de date pe care l-au creat folosind o anumită funcție matematică. Ei i-au cerut lui GPT-4 să deducă funcția matematică care a produs seria temporală, încercând să se răspundă la întrebarea „dacă GPT-4 poate explica în text înțelegerea sa asupra unei anumite serii temporale”, scriu Gruver și echipa sa.

Ei au descoperit că GPT-4 a fost capabil să ghicească funcția matematică mai bine decât modelele aleatorii, dar a produs câteva explicații care nu au fost înțelese. „Modelul face uneori deducții incorecte despre comportamentul datelor pe care le-a văzut sau despre comportamentul așteptat al funcțiilor date.” Cu alte cuvinte, chiar și atunci când un program precum GPT-4 poate prezice bine următorul lucru dintr-o serie temporală, explicațiile sale au tendința, uneori, de a oferi răspunsuri incorecte.

Gruver și echipa sa sunt entuziasmați de modul în care seriile temporale se potrivesc într-un viitor multimodal al inteligenţei artificiale. „Încadrarea prognozei seriilor cronologice prin generare de limbaj natural poate fi văzută ca un alt pas către unificarea mai multor capabilități într-un singur model mare și puternic, în care înțelegerea poate fi împărtășită între mai multe sarcini și modalități”, scriu cercetătorii în secțiunea finală.

Citeşte şi articolele:

- ChatGPT ştie şi limbaje de programare, unele chiar antice

- Cum să utilizați ChatGPT pentru a crea o aplicație (soft, program)

- 7 tehnici avansate de stimulare a ChatGPT-ului şi altor instrumente AI (Artificial Intelligence – Inteligenţă Artificială)

- OpenAI introduce o versiune de afaceri a ChatGPT, ChatGPT Enterprise

- Ce este ChatGPT Code Interpreter (interpretul de cod ChatGPT)